Los recientes avances de la IA no surgieron solo del software; fueron extraídos del silicio que dejó de pretender ser una computadora de propósito general. Los procesadores gráficos aprendieron una nueva gramática para el álgebra lineal. Los centros de datos unieron aceleradores como si fueran sistemas de órganos. Y ahora el hardware neuromórfico—máquinas que calculan con picos y tiempos en lugar de relojes y cuadros—pasa de la investigación a prototipos que ven, reaccionan y conservan energía con la eficiencia de un animal. El resultado no son solo modelos más rápidos, sino un cambio en dónde reside la inteligencia: menos en fortalezas en la nube y más en las manos, ruedas, alas y sensores que primero encuentran el mundo físico.

La historia comienza en un laboratorio abarrotado, lleno del zumbido de los ventiladores de enfriamiento, donde un par de tarjetas gráficas para juegos se convirtieron inesperadamente en el motor de un avance. En 2012, una red neuronal profunda entrenada en GPUs comerciales sacudió la visión por computadora de su largo estancamiento, y el campo nunca miró atrás. Los programadores que habían pasado años alimentando CPUs con bucles y ramas reconfiguraron sus mentes para pensar en matrices y núcleos. Las cadenas de herramientas se fortalecieron, CUDA se convirtió en un idioma común, y la idea de un chip optimizado para un tipo de matemáticas—álgebra lineal densa—dejó de sonar como una camisa de fuerza y más como una invitación.

El impulso se trasladó de los laboratorios a edificios enteros. Estantes de aceleradores aprendieron a actuar como uno solo, conectados por gruesos interconectores que transportan tensores tan fácilmente como pensamientos. La memoria dejó de ser un cuello de botella arrastrado a través de placas base y se convirtió en una pila situada a milímetros del cálculo, su ancho de banda medido menos por teoría que por el grosor del cobre en un paquete. Los planificadores manejaban miles de pequeñas tareas para que un transformador no muriera de inanición mientras esperaba su siguiente lote.

El contorno del futuro se definió: si la IA debe pensar en tiempo real—en calles, plantas de fabricación, en un exoesqueleto—el silicio debe estar construido para ese ritmo. La especialización reunió nombres y mascotas. Los chips tensoriales de Google se ajustaron para la danza de matrices de entrenamiento e inferencia en vastos pods. Microsoft entrelazó lógica programable en campo a través de sus servidores para que la búsqueda y la seguridad reaccionaran en microsegundos.

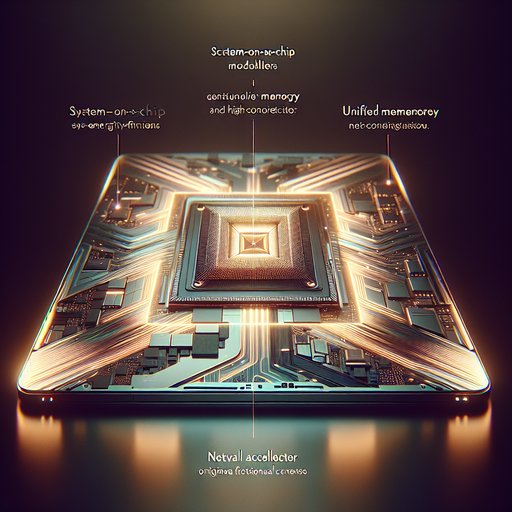

Apple incorporó un motor neuronal en el corazón palpitante del teléfono para que las fotos, el habla y la biometría pudieran mantenerse privadas y sentirse instantáneas. El patrón se sentía menos como una guerra de velocidades y más como una lección de geografía: diferentes formas de inteligencia prefieren diferentes terrenos, y el mapa del cálculo se diversificó en consecuencia. La precisión misma se volvió negociable. Donde los investigadores antes insistían en 32 o 64 bits, los diseñadores de hardware enseñaron a los modelos a prosperar con menos—primero media precisión, luego bfloat, luego formatos que encajan la curva de un exponencial en un carril más estrecho.

Los núcleos tensoriales y las matrices sistólicas encontraron ritmo en la regularidad, mientras los compiladores podaban ramas incómodas y explotaban la esparsidad de la misma manera que un escultor encuentra una figura dentro de la piedra. El trabajo que había llevado semanas se redujo a días, luego a horas. La ganancia no fue solo en rendimiento; fue legitimidad para un credo que daría forma a los próximos experimentos: co-diseñar el algoritmo con el sustrato que le dará vida. Los chips mismos comenzaron a parecer audaces.

Algunas empresas unieron matrices en chiplets y los conectaron a través de interposers de silicio, convirtiendo lo que solía ser una placa base en un solo organismo. Otros fueron más allá e hicieron que toda una oblea actuara como un solo dispositivo—sin paredes de retícula, sin viajes incómodos fuera del chip—para que un océano de cálculo pudiera sentarse junto a un mar de memoria en la oblea. Las telas de red crecieron en planos de fondo que tratan docenas de aceleradores como un solo nodo. En estas salas, un investigador puede apuntar un modelo cavernoso a los datos y verlo aprender más rápido que la última vez, no porque las matemáticas sean diferentes, sino porque la pista es más larga y suave.

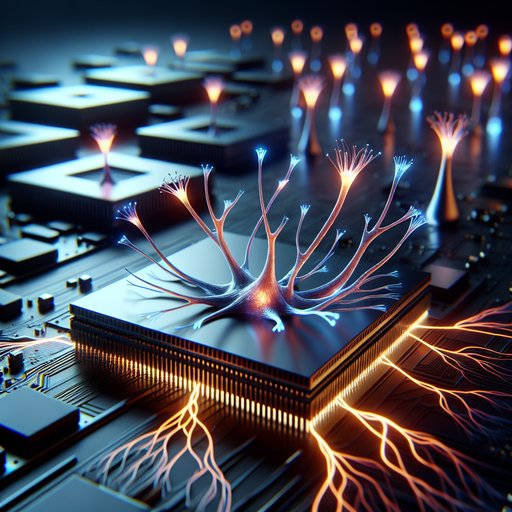

Luego, otra rama del árbol genealógico se despertó. Los chips neuromórficos—bocetos de corteza dibujados en CMOS—escuchan en picos y hablan en tiempos precisos. Los primeros experimentos de IBM mostraron que un millón de neuronas de software pueden habitar en un chip del tamaño de un sello sin consumir mucha energía. Las plataformas de investigación de Intel impulsaron la idea de la adaptación en el chip, para que las redes no solo ejecuten comportamientos aprendidos; también cambien a medida que perciben.

En Manchester, una máquina tejida a partir de un enjambre de núcleos simples modeló redes de picos en escalas de tiempo biológicas. Ninguno de estos sistemas pretende vencer a una GPU en la multiplicación de matrices densas. Buscan un premio diferente: moverse por el mundo con gracia con un susurro de energía. Puedes vislumbrar ese premio en dispositivos que no esperan fotogramas.

Cámaras basadas en eventos de startups europeas envían solo los píxeles que cambian, como una retina canalizando impulsos directamente al nervio óptico. Combinadas con procesadores de picos, guían drones del tamaño de la palma de la mano entre ramas sin agotar sus baterías, o estabilizan manos robóticas mientras ruedan una semilla entre los dedos. Las pieles táctiles informan de transitorios de presión en lugar de escaneos periódicos, permitiendo que las pinzas sostengan fruta madura como lo haría un niño—escuchando microdeslizamientos en lugar de calcular un promedio. El bucle entre percepción y acción se reduce, y el comportamiento de un robot comienza a parecerse más a reflejos que a deliberación.

La computación analógica y en memoria añade otra subtrama. En los laboratorios, los ingenieros persuaden a matrices de dispositivos resistivos para realizar la operación central del aprendizaje profundo—multiplicar y acumular—dejando que las corrientes se sumen donde viven los pesos. Parece un regreso a las reglas de cálculo y los amplificadores operacionales, pero el efecto es moderno: drásticamente menos tráfico entre memoria y cálculo. Los componentes derivan y exigen calibración.

La temperatura empuja bits. Pero la promesa persiste: un modelo que se entrena o ajusta dentro del mismo tejido que lo almacena, consumiendo energía donde las máquinas digitales tragarían. Combina eso con control digital, y la línea entre almacenamiento y pensamiento se suaviza. Todo este poder crea su propio clima.

Los centros de datos negocian dietas eléctricas con las compañías de servicios públicos; diez megavatios aquí, luego veinte. Las fábricas reservan trimestres del calendario para empaquetado avanzado porque la demanda es tan escasa como sagrada. Las cadenas de herramientas desde compiladores hasta perfiles se convierten en guardianes de lo que es incluso imaginable, decidiendo qué arquitecturas de modelos aprovechan las fortalezas de un chip y cuáles se quedan sin recursos debido a sus peculiaridades. La geopolítica de la litografía y el suministro de sustratos se alinean detrás de las hojas de ruta de investigación, y la sostenibilidad no es un comunicado de prensa sino la diferencia entre una ciudad que mantiene sus luces y una que parpadea.

Sin embargo, el horizonte se niega a asentarse en una sola silueta. En una dirección, aceleradores cada vez más densos atraen más inteligencia a nubes compartidas donde los modelos pueden ser entrenados en memoria colectiva y alquilados por milisegundos. En otra, la computación neuromórfica y en sensores empuja la cognición hacia afuera, en prótesis que se ajustan a medida que cambia el paso de un corredor, en audífonos que siguen la voz que te importa, en células de fábrica que se desvían menos porque sienten el torque en lugar de muestrearlo. Entre ellos yace una pregunta que la historia sigue haciendo a los nuevos medios: cuando el sustrato cambia el arte, ¿qué nuevas formas serán posibles, y qué viejas suposiciones tendremos que desaprender?

Estamos reaprendiendo que el rendimiento, al final, no es solo un número más alto en un gráfico. Es una latencia sensorial lo suficientemente baja como para que una máquina pueda compartir nuestro tiempo. Es un presupuesto de energía lo suficientemente suave como para que la inteligencia pueda vivir donde está el trabajo. Es un apretón de manos entre hardware y software lo suficientemente honesto como para que cada uno informe al otro sin pretensiones.

Los chips especializados y el hardware neuromórfico no son un desvío de la generalidad; son un recordatorio de que la inteligencia general puede necesitar muchos cuerpos específicos. El próximo límite no se cruzará solo en teoría, sino en silicio que piensa con nosotros, a nuestro ritmo, en los lugares que más nos importan.